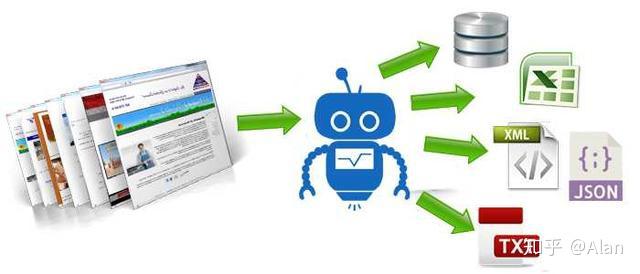

随着互联网技术的飞速发展,网络爬虫已成为数据采集的重要工具。爬虫能够自动化地访问网页、收集数据信息,从而为各类研究、商业和数据分析提供支持。使用爬虫的过程中,IP被封禁的问题日益突出,这也催生了IP代理技术的广泛应用。本文将全面解析爬虫IP代理的工作原理以及其在网络爬虫中的重要性。

我们需要清楚网络爬虫的基本工作方式。网络爬虫是自动通过HTTP协议请求网页内容的程序。爬虫会发送请求到特定的URL,解析返回的HTML内容,提取所需的数据。爬虫在频繁请求同一网页时,容易触发目标网站的反爬虫机制。许多网站会通过分析请求的IP地址来判断是否有异常流量,一旦检测到某个IP地址发起过多请求,就会将其封禁,导致爬虫无法继续工作。

为了解决这个问题,爬虫开发者通常会使用IP代理。IP代理是通过中间服务器转发请求的技术。当爬虫向目标网站发起请求时,实际上请求是通过代理服务器进行的。代理服务器会将请求中的IP地址替换为其自身的IP地址,从而有效地隐藏原始请求的来源。这种方法不仅能够提高爬虫的隐匿性,还可以避免因IP被封禁而导致的爬虫失效。

IP代理的种类主要分为三种:透明代理、匿名代理和高匿名代理。透明代理不会隐藏用户的真实IP地址,目标网站可以很容易地识别出用户的真实身份;匿名代理会隐藏用户的真实IP地址,但是目标网站仍然可以检测到使用了代理。当使用高匿名代理时,代理服务器完全不在请求中暴露用户的真实IP地址,因此目标网站无法判断是否使用了代理。这三种代理各有特点,开发者应根据实际需求选择适合的代理类型。

除了隐匿用户IP地址,代理服务器在网络爬虫中的应用还有助于提高爬虫的并发能力。当爬虫需要从多个网页同时抓取数据时,使用多个代理可以有效分散请求压力,避免因请求过于集中而导致的被封禁风险。基于不同的代理IP,爬虫能够在短时间内发起大量请求,而不会被网站的防护机制所察觉。

在使用IP代理时,选择高质量的代理服务至关重要。市面上有许多免费的IP代理,但其稳定性和速度往往无法保证。相较之下,付费的IP代理服务通常能够提供更快的连接速度和更高的可用性。一些专业的代理服务还会定期更新IP池,从而确保用户可以始终使用新鲜的IP地址。高质量的代理服务能够显著提高爬虫的成功率以及数据抓取的质量。

当然,在使用爬虫与IP代理的过程中,须遵循相关法律法规与道德规范。各大网站通常会在其服务条款中明确说明禁止使用爬虫工具进行数据抓取。因此,开发者在应用爬虫和代理时,应始终确保自己的行为不侵犯他人的合法权益,避免造成不必要的法律风险。

IP代理在网络爬虫中扮演着重要的角色。它不仅能够隐藏真实IP、提高并发能力,还可以有效规避网站的反爬虫机制。使用IP代理的同时,开发者也需保持敬畏之心,遵循法律与道德规范,以确保爬虫技术在健康、有序的环境中发展。随着爬虫技术的不断进步与应用,IP代理的技术也会不断发展完善,为数据的获取与分析提供更为可靠的保障。

亿动网

亿动网